¿Y si pudieras tener tu propio ChatGPT en casa, sin pagar suscripción, sin enviar tus datos a la nube y sin depender de internet? Con Ollama, la herramienta de código abierto con más de 94.000 estrellas en GitHub, puedes ejecutar modelos de inteligencia artificial como Llama 3.3, DeepSeek-R1, Gemma 3 y Qwen 3 directamente en tu PC. En esta guía paso a paso te enseñamos a instalarlo, configurarlo y sacarle el máximo partido en 2026.

¿Qué es Ollama y por qué usarlo?

Ollama es una herramienta de código abierto (licencia MIT) que te permite descargar y ejecutar modelos de lenguaje (LLMs) directamente en tu ordenador. Piensa en ello como un "Docker para modelos de IA": con un solo comando puedes tener funcionando modelos como Llama 3.3 de Meta, DeepSeek-R1 o Gemma 3 de Google sin necesidad de crear cuentas ni pagar suscripciones.

¿Por qué elegir IA local en lugar de ChatGPT, Claude o Gemini? Hay varias razones de peso:

- Privacidad total: tus datos nunca salen de tu ordenador. Ni una sola consulta viaja a servidores externos

- Sin coste mensual: una vez descargado el modelo, lo usas gratis para siempre

- Funciona sin internet: ideal para trabajar offline, en aviones o zonas sin cobertura

- Personalizable: puedes crear modelos ajustados a tus necesidades con Modelfiles

- API compatible con OpenAI: cualquier aplicación que funcione con ChatGPT puede usar Ollama como backend

Requisitos de hardware

La gran pregunta: ¿puede mi PC ejecutar IA local? La respuesta corta es que casi cualquier ordenador moderno puede ejecutar modelos pequeños, pero para modelos más grandes necesitarás más recursos. La memoria RAM y la VRAM de la GPU son los factores clave.

Requisitos por tamaño de modelo

| Modelo | Parámetros | RAM mínima | VRAM GPU recomendada | Ejemplo |

|---|---|---|---|---|

| Pequeño | 1-3B | 8 GB | 4 GB | Gemma 2 2B, Qwen 2.5 3B |

| Mediano | 7-8B | 16 GB | 8 GB | Llama 3.1 8B, Mistral 7B |

| Grande | 13-14B | 32 GB | 16 GB | DeepSeek-R1 14B, Qwen 3 14B |

| Muy grande | 70B+ | 64 GB | 40-48 GB | Llama 3.3 70B, DeepSeek-R1 70B |

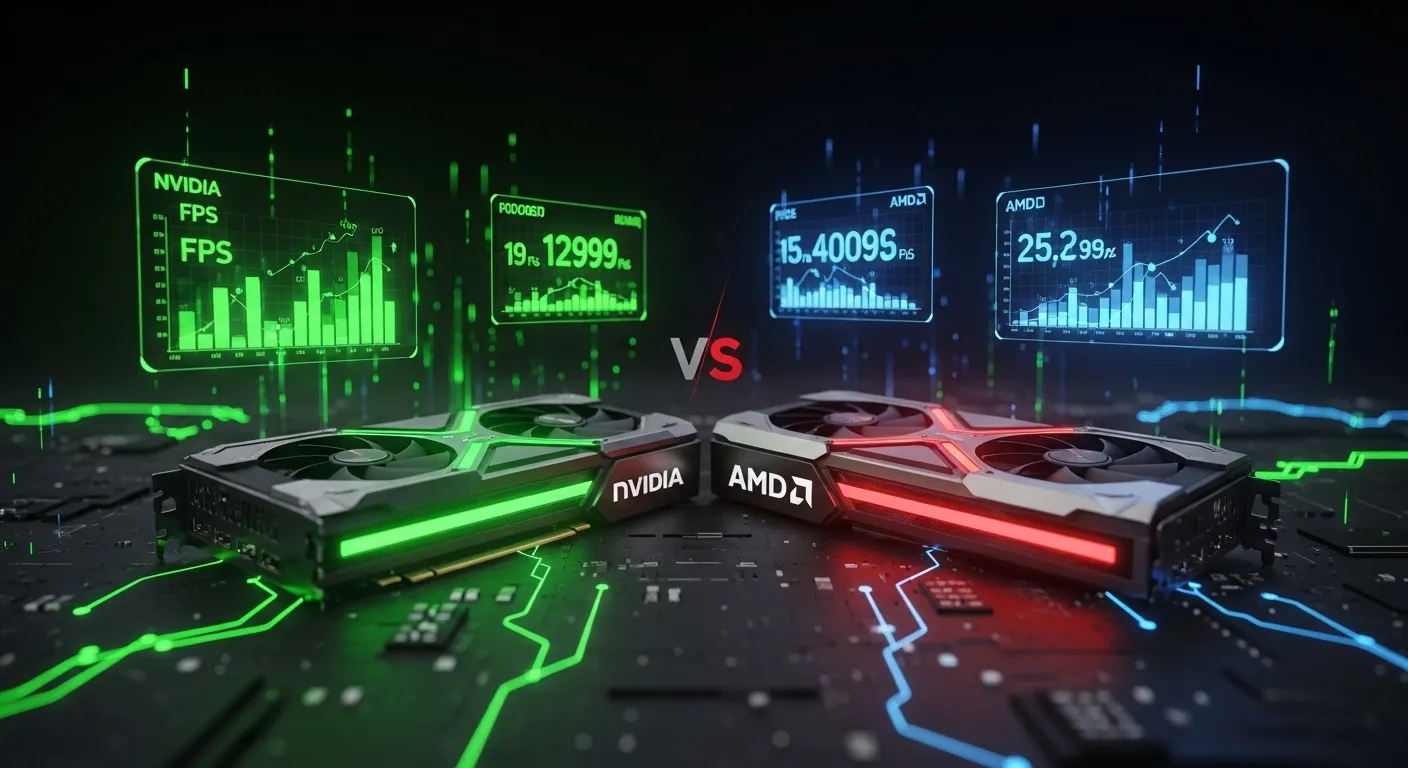

¿GPU o CPU?

Ollama funciona tanto con GPU como solo con CPU, pero la diferencia de rendimiento es enorme:

| Modo | Velocidad típica | Experiencia |

|---|---|---|

| GPU (NVIDIA/AMD) | 40-80 tokens/s | Respuestas casi instantáneas, conversación fluida |

| Solo CPU | 4-20 tokens/s | Usable pero notablemente más lento |

GPUs compatibles

- NVIDIA: cualquier GPU con Compute Capability 5.0+ (GTX 900 series en adelante). Las RTX 3060 12GB y RTX 4060 Ti 16GB son excelentes opciones calidad-precio

- AMD: soporte completo en Linux y Windows (añadido en 2025)

- Apple Silicon: M1, M2, M3 y M4 con memoria unificada — rendimiento excelente

Si estás pensando en actualizar tu GPU para IA local, consulta nuestra guía de las mejores tarjetas gráficas de 2026.

Instalación paso a paso

Ollama está disponible para Windows, macOS y Linux. La instalación es sorprendentemente sencilla.

Linux (una línea)

curl -fsSL https://ollama.com/install.sh | shEste comando descarga e instala Ollama automáticamente. En distribuciones como Ubuntu, Fedora o Arch funciona sin problemas.

Windows

- Descarga el instalador desde ollama.com/download

- Ejecuta el archivo .exe descargado

- Sigue el asistente de instalación (siguiente, siguiente, instalar)

- Ollama se ejecutará en la bandeja del sistema

macOS

- Descarga el archivo .dmg desde ollama.com/download

- Arrastra Ollama a la carpeta Aplicaciones

- Abre Ollama desde Aplicaciones

Docker (para servidores y avanzados)

docker run -d --gpus all -p 11434:11434 --name ollama ollama/ollamaCon Docker tienes la ventaja de aislar Ollama del sistema y poder desplegarlo en servidores remotos o clústeres Kubernetes.

Verificar la instalación

Abre una terminal y ejecuta:

ollama --versionSi ves algo como ollama version 0.16.1 (o superior), la instalación ha sido exitosa. Ahora vamos a descargar tu primer modelo.

Tu primera conversación con IA local

ollama run llama3.1:8bEste comando descarga el modelo Llama 3.1 de 8B parámetros (~4.7 GB) y abre una conversación directa en la terminal. Ya tienes tu propia IA funcionando en local.

Los mejores modelos para cada uso

Ollama cuenta con más de 100 modelos en su biblioteca. Aquí tienes los mejores según tu caso de uso:

Para uso general (chatear, preguntar, resumir)

| Modelo | Tamaño | Comando | Ideal para |

|---|---|---|---|

| Llama 3.3 70B | 40 GB | ollama run llama3.3:70b | Máxima calidad, iguala a GPT-4 en muchas tareas |

| Llama 3.1 8B | 4.7 GB | ollama run llama3.1:8b | Mejor relación calidad/tamaño, funciona en cualquier GPU moderna |

| Gemma 3 9B | 5.4 GB | ollama run gemma3 | Multimodal (entiende imágenes), muy eficiente |

| Qwen 3 14B | 8.9 GB | ollama run qwen3:14b | Excelente en 29 idiomas, incluido español |

Para programación

| Modelo | Tamaño | Comando | Ideal para |

|---|---|---|---|

| DeepSeek Coder | Varía | ollama run deepseek-coder | 87 lenguajes, entrenado con 2T tokens de código |

| Qwen 2.5 Coder 7B | 4.4 GB | ollama run qwen2.5-coder:7b | Autocompletado y generación de código |

| CodeLlama 34B | 19 GB | ollama run codellama:34b | Proyectos grandes, comprensión multi-archivo |

Para razonamiento avanzado

| Modelo | Tamaño | Comando | Ideal para |

|---|---|---|---|

| DeepSeek-R1 14B | 8.9 GB | ollama run deepseek-r1:14b | Razonamiento paso a paso, se acerca a O3 de OpenAI |

| DeepSeek-R1 70B | 43 GB | ollama run deepseek-r1:70b | Razonamiento de nivel investigación |

Comandos esenciales

Ollama se controla desde la terminal con comandos sencillos. Aquí tienes los que usarás a diario:

| Comando | Descripción |

|---|---|

ollama run modelo | Ejecuta un modelo (lo descarga si no lo tienes) |

ollama pull modelo | Descarga un modelo sin ejecutarlo |

ollama list | Muestra todos los modelos descargados |

ollama rm modelo | Elimina un modelo descargado |

ollama show modelo | Muestra información detallada del modelo |

ollama serve | Inicia el servidor API (se ejecuta automáticamente) |

ollama ps | Muestra los modelos actualmente cargados en memoria |

ollama launch herramienta | Conecta directamente con herramientas como Claude Code o Codex |

Atajos dentro del chat

/bye— Salir de la conversación/clear— Limpiar el historial de la sesión/set parameter valor— Ajustar parámetros como temperatura o contexto/show info— Ver información del modelo activo

Instalar una interfaz gráfica con Open WebUI

Si prefieres una experiencia visual similar a ChatGPT en lugar de la terminal, Open WebUI es la mejor opción. Es una interfaz web gratuita y de código abierto que se conecta a Ollama.

Instalación con Docker (recomendado)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainDespués abre tu navegador en http://localhost:3000 y tendrás una interfaz idéntica a ChatGPT pero usando tus modelos locales.

¿Qué ofrece Open WebUI?

- Chat con múltiples modelos — cambia entre Llama, DeepSeek, Gemma con un clic

- Historial de conversaciones — todas tus charlas guardadas y organizadas

- Subida de documentos — arrastra PDFs e imágenes para que el modelo los analice

- RAG integrado — búsqueda en tus documentos para respuestas basadas en tus propios datos

- Multi-usuario — varios usuarios pueden usar la misma instalación con cuentas separadas

Casos de uso prácticos

Más allá de chatear, Ollama tiene aplicaciones prácticas que pueden ahorrarte tiempo y dinero:

Asistente de programación

Usa DeepSeek Coder o Qwen 2.5 Coder como copiloto de código. Con la extensión Continue.dev para VS Code puedes tener autocompletado inteligente, refactorización y explicación de código directamente en tu editor, sin enviar tu código a la nube.

ollama launch claude-codeEl nuevo comando ollama launch (añadido en octubre 2025) conecta directamente con herramientas de desarrollo como Claude Code, Codex u OpenCode sin configuración adicional.

Análisis de documentos privados

¿Tienes contratos, informes médicos o documentos confidenciales que quieres analizar con IA? Con Ollama + Open WebUI puedes arrastrar PDFs directamente a la interfaz y hacer preguntas sobre su contenido. Todo se procesa en local.

Generación de contenido

Escribe borradores de artículos, emails profesionales, posts para redes sociales o descripciones de productos. Modelos como Llama 3.3 70B producen textos de calidad comparable a GPT-4 para muchas tareas.

Traducción multilingüe

Qwen 3 soporta 29 idiomas con fluidez nativa. Puedes traducir documentos completos sin límites de caracteres ni costes por uso.

Generación de imágenes (experimental)

Desde enero de 2026, Ollama soporta generación de imágenes de forma experimental con modelos como FLUX.2 [klein] y Z-Image-Turbo. Actualmente solo en macOS, con soporte para Windows y Linux en desarrollo.

Si quieres explorar más herramientas de IA gratuitas, no te pierdas nuestra guía de las mejores herramientas de IA gratis en 2026.

Privacidad y seguridad

Esta es la mayor ventaja de Ollama frente a servicios en la nube. Cuando usas ChatGPT o Claude, tus conversaciones viajan a servidores de OpenAI o Anthropic. Con Ollama, todo se queda en tu máquina.

Ventajas de privacidad

- Zero data leakage: ningún dato sale de tu red local

- Sin telemetría: Ollama es open source, puedes auditar el código

- Cumplimiento normativo: compatible con GDPR, PCI DSS y normativas de protección de datos

- Modo offline: una vez descargados los modelos, no necesitas conexión a internet

- Variable OLLAMA_NO_CLOUD: desactiva cualquier conexión a modelos en la nube si lo deseas

export OLLAMA_NO_CLOUD=1

ollama serveIdeal para profesionales

Especialmente útil para abogados (documentos confidenciales), médicos (datos de pacientes), desarrolladores (código propietario) y empresas (datos financieros sensibles) que no pueden enviar información a servidores de terceros.

Secure Minions: lo mejor de ambos mundos

Si necesitas la potencia de un modelo en la nube pero no quieres exponer tus datos, Ollama incluye el protocolo Secure Minions (desarrollado con Stanford). Tu modelo local procesa la información sensible y solo envía consultas cifradas al modelo en la nube. Resultado: 98% de la precisión del modelo cloud con 5-30x menos coste y privacidad garantizada.

Ollama vs alternativas

Ollama no es la única opción para ejecutar IA en local. ¿Cómo se compara con las alternativas?

| Característica | Ollama | LM Studio | GPT4All | vLLM |

|---|---|---|---|---|

| Interfaz | Terminal + App de escritorio | GUI completa | GUI + Chat | Solo API/CLI |

| Facilidad de uso | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ |

| Rendimiento | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| API OpenAI | Sí | Sí | Limitada | Sí |

| Docker/K8s | Sí | No | No | Sí |

| Ideal para | Desarrolladores, DevOps | Usuarios no técnicos | Principiantes | Producción empresarial |

| Único | Modelfiles, Secure Minions, generación de imágenes | Vulkan GPU offload | LocalDocs Q&A | Paged Attention, máximo throughput |

Veredicto: Ollama es la mejor opción para desarrolladores y usuarios que quieran un equilibrio entre simplicidad, potencia y flexibilidad. Si eres completamente nuevo en IA local y no quieres tocar la terminal, empieza con LM Studio o GPT4All y luego migra a Ollama cuando necesites más control.

Para entender mejor cómo la IA local encaja en el ecosistema actual, lee nuestro artículo sobre agentes de IA en 2026.

Consejos para optimizar el rendimiento

Sácale el máximo partido a Ollama con estos trucos:

1. Usa modelos quantizados

Los modelos vienen en diferentes niveles de cuantización (Q4, Q5, Q8). Los modelos Q4_K_M ofrecen el mejor equilibrio entre calidad y uso de memoria. Es lo que Ollama descarga por defecto.

2. Ajusta el contexto

Por defecto, el contexto es de 2048 tokens. Si necesitas que el modelo recuerde más información en la conversación:

ollama run llama3.1:8b --num-ctx 8192Ten en cuenta que más contexto = más VRAM utilizada.

3. Mantén los drivers actualizados

Asegúrate de tener los últimos drivers de NVIDIA (con soporte CUDA) o AMD. Ollama soporta Flash Attention 2.0 en GPUs Ampere+ (RTX 30XX en adelante), lo que reduce el uso de memoria hasta un 30%.

4. Usa SSD para almacenamiento

Los modelos se cargan desde disco a memoria. Un SSD NVMe reduce significativamente los tiempos de carga iniciales frente a un HDD.

5. Multi-GPU

Si tienes dos GPUs, Ollama puede dividir el modelo entre ambas automáticamente. Ideal para modelos de 70B que no caben en una sola tarjeta.

Novedades de Ollama en 2026

Ollama no para de evolucionar. Estas son las funcionalidades más importantes añadidas recientemente:

- App de escritorio nativa (julio 2025): interfaz con chat, drag-and-drop de documentos y slider de contexto

- Generación de imágenes (enero 2026): soporte experimental para FLUX.2 y Z-Image-Turbo

- Modelos en la nube: conecta con modelos frontier además de los locales, con opción de desactivarlo completamente

- Búsqueda web integrada (noviembre 2025): los modelos pueden buscar información actualizada en internet

- Ollama Launch (octubre 2025): integración directa con herramientas de desarrollo

- Structured Outputs: respuestas en JSON Schema validado, perfecto para integraciones programáticas

- Thinking Mode: modo de razonamiento visible para modelos como DeepSeek-R1

Preguntas Frecuentes

¿Ollama es gratis?

Sí, Ollama es completamente gratuito y de código abierto (licencia MIT). Los modelos también son gratuitos para descargar y usar. Existe Ollama Turbo ($20/mes) como servicio cloud opcional, pero no es necesario.

¿Qué modelo debo elegir si solo tengo 8 GB de RAM?

Con 8 GB de RAM puedes ejecutar modelos de hasta 3B parámetros como Gemma 2 2B o Qwen 2.5 3B. Si tienes GPU, estos modelos funcionan sorprendentemente bien para tareas básicas como resúmenes, traducciones y preguntas generales.

¿Ollama funciona sin internet?

Sí. Una vez que hayas descargado los modelos, Ollama funciona completamente offline. Solo necesitas internet para descargar modelos nuevos o actualizaciones. Puedes incluso activar OLLAMA_NO_CLOUD=1 para bloquear cualquier conexión externa.

¿Los modelos locales son tan buenos como ChatGPT?

Depende del modelo y la tarea. Llama 3.3 70B iguala a GPT-4 en muchas tareas y DeepSeek-R1 se acerca a O3 en razonamiento. Para modelos de 7-8B, la calidad es inferior a GPT-4 pero más que suficiente para la mayoría de usos cotidianos.

¿Puedo usar Ollama como backend para aplicaciones?

Sí. Ollama expone una API REST compatible con OpenAI en http://localhost:11434. Cualquier aplicación que funcione con la API de OpenAI puede apuntar a Ollama sin cambios. También tiene bibliotecas oficiales para Python y JavaScript, e integración con LangChain y LlamaIndex.

¿Cuánto espacio en disco necesito?

Depende de los modelos que descargues. Un modelo de 7-8B ocupa unos 4-5 GB, uno de 14B unos 8-9 GB y uno de 70B alrededor de 40 GB. Recomendamos tener al menos 50 GB libres en un SSD para tener 2-3 modelos instalados cómodamente.

Comentarios

Inicia sesion para dejar un comentario

Acceder